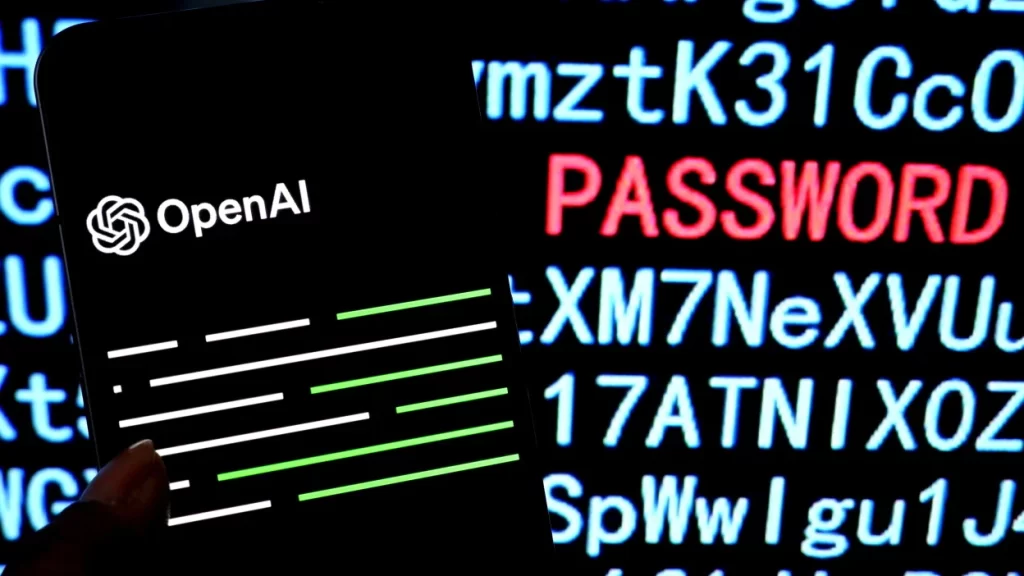

超过 22万个被盗的 ChatGPT 凭证在暗网出售

去年,至少有 225,000 组 OpenAI 凭证在暗网上出售,这些凭证可能被用来访问发送到 ChatGPT 的敏感数据。

Group-IB 的研究人员在 2023 年 1 月至 10 月期间发现了受到信息窃取恶意软件危害的 ChatGPT 帐户,其发现于周四发布在 Group-IB 的《2023/2024 年高科技犯罪趋势报告》中。

被盗凭证是在暗网市场上出售的日志的一部分,这些日志来自感染LummaC2、Raccoon和RedLine 等信息窃取者的设备。这些恶意软件工具搜索并收集存储在受感染设备上的敏感详细信息,例如登录凭据和财务信息。

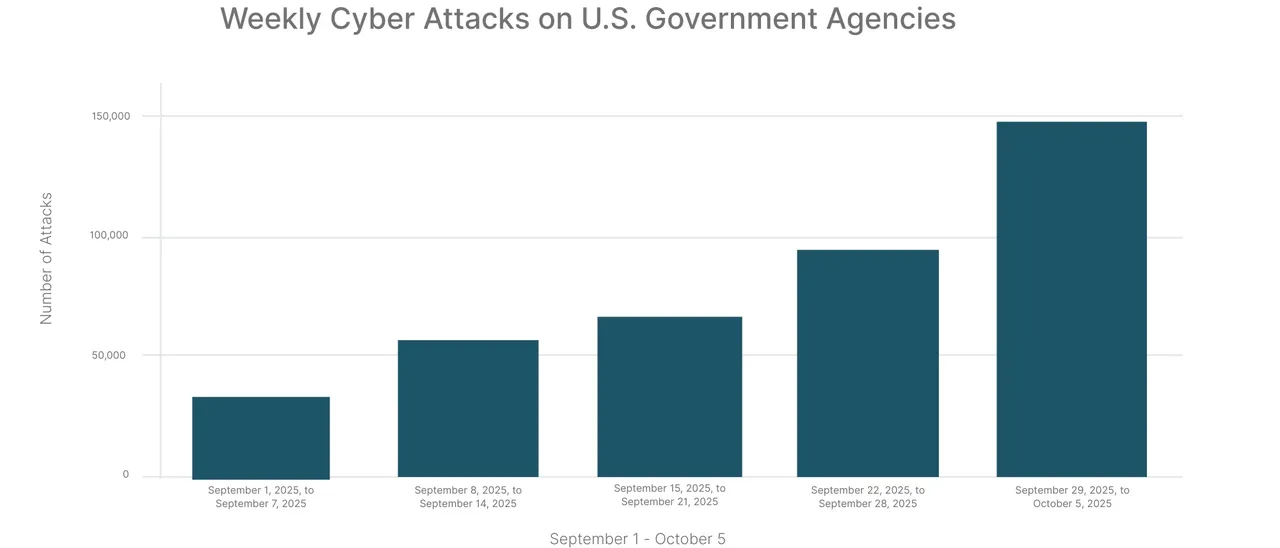

Group-IB 研究的前五个月和最后五个月期间,ChatGPT 访问凭据泄露增加了 36%,2023 年 6 月至 10 月期间发现了超过 130,000 台受感染主机,而 1 月至 5 月期间发现了不到 96,000 台受感染主机。在该研究的最后一个月,OpenAI 凭证被盗事件最多,总计 33,080 起。

LummaC2 是 2023 年 6 月至 10 月期间包含 ChatGPT 凭证的信息窃取者日志的最常见来源,有 70,484 个案例,其次是 Raccoon 和 RedLine,各少于 23,000 个案例。

这与Group-IB 之前的数据有所不同,该数据显示,2022 年 6 月至 2023 年 5 月期间,Raccoon 是迄今为止最常见的 OpenAI 详细信息窃取者(超过 78,000 次感染),其次是Vidar和 RedLine。

“许多企业正在将 ChatGPT 集成到他们的运营流程中。员工输入机密信件或使用机器人来优化专有代码,”Group-IB 威胁情报主管 Dmitry Shestakov 在去年的一份声明中表示。“鉴于 ChatGPT 的标准配置保留了所有对话,如果威胁行为者获得帐户凭据,这可能会无意中向他们提供大量敏感情报。”

员工将敏感数据、机密文档输入 ChatGPT

随着人们对企业员工冒险使用生成式人工智能的了解越来越多,有关 ChatGPT 帐户泄露的最新数据也随之而来。

LayerX 2023 年 6 月的一份报告发现,6% 的企业员工至少将敏感数据粘贴到 gen AI 应用程序中一次,4% 的企业员工“每周”将敏感数据粘贴到这些应用程序中。在这些暴露中,43% 包括内部业务数据,31% 包括源代码,12% 包括个人身份信息 (PII)。

Cyberhaven 于 2023 年 6 月进行的一项类似研究专门针对 ChatGPT,也得出了类似的结果。该研究发现,4.7%的员工将敏感数据粘贴到ChatGPT中,当年3月4日至4月15日期间,每10万名员工泄露到ChatGPT的机密数据事件增加了60.4%。

最近,Menlo Security 在 2024 年 2 月的一份报告中表示,2023 年 7 月至 12 月期间,企业员工尝试将文件上传到 gen AI 网站的次数增加了 80%。这可能是由于 OpenAI 增加了高级用户上传文件的能力10 月份将文件直接上传到 ChatGPT。

值得注意的是,根据 Menlo Security 的数据,近 40% 的新一代人工智能应用程序尝试敏感输入包括机密文档,其中一半以上包括 PII。

OpenAI 本身在 2023 年 3 月遭遇了数据泄露,原因是一个漏洞暴露了 1.2% 的 ChatGPT Plus 用户的姓名、电子邮件地址和支付信息。

Menlo Security 建议组织采取分层方法来防止敏感信息因使用人工智能而泄露。这可以包括实施复制粘贴控制,以防止将大量文本或已知专有代码粘贴到输入字段中,以及放置 gen AI 组级安全控制,而不是逐个域地阻止 gen AI 网站。(安全客)