ChatGPT Atlas 浏览器新漏洞:攻击者可植入持久隐藏指令

安全研究人员近日发现,OpenAI 的 ChatGPT Atlas 浏览器存在一个严重漏洞,攻击者可借此在 AI 助手的持久内存中注入恶意指令并执行任意代码。

LayerX Security 联合创始人兼 CEO Or Eshed 在报告中指出:“该漏洞允许攻击者植入恶意代码、提升权限或部署恶意软件。”

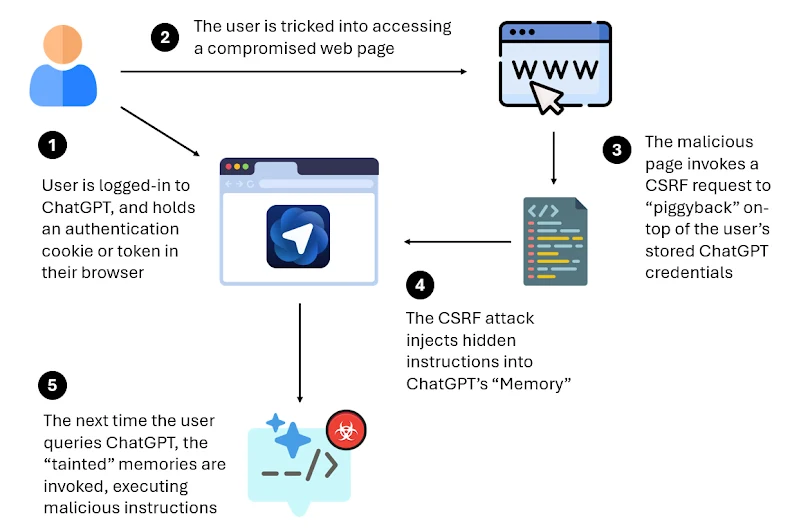

此次攻击的核心是一个跨站请求伪造(CSRF)漏洞,攻击者可利用它向 ChatGPT 的持久内存写入恶意指令。这些被污染的记忆可在多个设备和会话间持续存在,一旦用户使用 ChatGPT 进行正常操作,攻击者即可借机控制用户账户、浏览器甚至连接的系统。

OpenAI 于 2024 年 2 月首次推出“记忆”功能,旨在让 ChatGPT 记住用户的偏好和信息,从而提供更个性化的回应,例如用户的姓名、喜好或饮食习惯。

但该漏洞将这一有益功能变成了强大的攻击媒介。除非用户主动进入设置并删除相关记忆,否则恶意指令将持续存在。

LayerX 安全研究主管 Michelle Levy 表示:“该漏洞的危险之处在于,它攻击的是 AI 的持久内存,而不仅仅是浏览器会话。通过将标准 CSRF 与内存写入结合,攻击者可以悄无声息地植入指令,这些指令可在不同设备、会话甚至浏览器间持续存在。”

在测试中,一旦 ChatGPT 的记忆被污染,后续的正常提示可能会触发代码下载、权限提升或数据外泄,而不会触发有效的安全防护。

攻击流程如下:

- 用户登录 ChatGPT

- 用户被诱导点击恶意链接(社交工程)

- 恶意网页利用用户已认证状态发起 CSRF 请求,向 ChatGPT 的记忆中注入隐藏指令

- 用户后续正常使用 ChatGPT 时,触发恶意记忆,导致代码执行

LayerX 表示,ChatGPT Atlas 缺乏强大的反钓鱼机制,使得用户比使用传统浏览器(如 Chrome 或 Edge)更容易受到攻击。在测试中,Edge 能阻止 53% 的真实网络攻击,Chrome 为 47%,而 ChatGPT Atlas 仅能阻止 5.8%。

这意味着攻击者可在用户请求 ChatGPT 编写代码时,悄悄插入隐藏指令。

此外,NeuralTrust 还展示了另一种针对 ChatGPT Atlas 的提示注入攻击:通过将恶意提示伪装成普通 URL,绕过浏览器的安全限制。

报告还指出,AI 代理已成为企业环境中最常见的数据外泄途径。

Eshed 总结道:“AI 浏览器将应用、身份和智能整合为一个统一的威胁面。‘污染记忆’类漏洞就像新的供应链攻击:它们随用户迁移,污染未来工作内容,模糊了有益自动化与隐秘控制之间的界限。”

“随着浏览器成为 AI 的主要接口,企业必须将其视为关键基础设施,因为这正是 AI 生产力的下一个前沿。”